近日,小米推出了全面支持情感化语音交互的小米小爱音箱Art,小米也成为业内首家情感化TTS大规模落地的企业。

基于开心、关心、害羞等有限但类型不同的情感音频数据,通过不同技术训练并迭代声学模型,这款音箱支持情感TTS合成,并实现了“小爱同学”的音感化、拟人化。

随着人工智能技术的发展,在实现人机对话的基础上,各大AI企业都在情感化语音交互的领域积极展开探索。

例如在智能客服领域,当用户的问题无法解决或者问题表述不清时,智能客服很有可能无法识别用户的情绪、进行进一步操作,从而引发用户的不满和投诉。

针对这一情况,日本NTT研究所研发出一款客服电话情感识别系统,对用户的电话语音进行收集处理,如果未检测到用户愤怒的情感,则继续当前的语音服务;如果检测到愤怒的情感,则转为人工服务进行业务处理。

语音情感识别通常指机器从语音中自动识别人类情感和情感相关状态的过程。通过分析说话人情绪使机器进行拟人化的互动,识别说话人的情感成为语音技术发力的一个新热点。

语音情感识别包括两种,NTT推出的客服电话情感识别系统属于只通过声音来分析情感。这一情感语音识别模型的落地应用离不开训练数据的支撑。

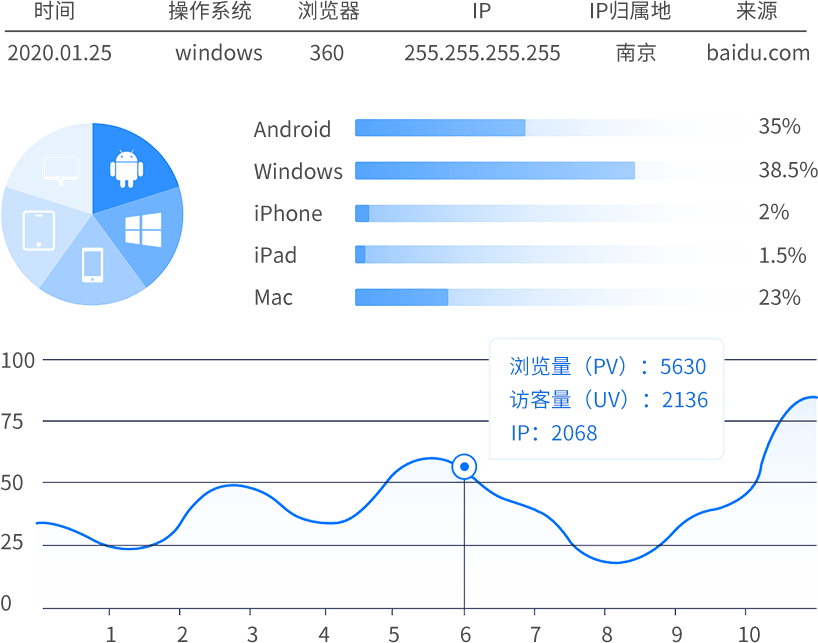

数据堂深耕于AI数据领域近十年,一直致力于为全球人工智能企业提供专业的数据服务,行业内高标准的语音情感识别训练数据《20人英文情感语音麦克风采集数据》和《30部电影语音视频标注数据》广受重视和好评。

语音情感识别的另外一种模型就是结合声音和图像的多模态情感分析。

机器人Pepper就是应用多模态情感分析的典型案例。

Pepper是由日本软银集团和法国Aldebaran Robotics研发的一款人形机器人,可综合考虑周围环境,积极主动地作出反应。

Pepper配备了语音识别技术以及分析表情和声调的情绪识别技术,经过定制化开发,可通过表情、动作、语音与人类交流、反馈,甚至能够跳舞、开玩笑。

如今在商业领域,全球超过2000家企业应用了Pepper,服务于零售、金融、健康护理等众多行业。

麻省理工学院媒体实验室分拆公司Affectiva通过语音和面部数据打造了情感档案,其神经网络SoundNet可以在短短1.2秒内识别出音频数据中的愤怒情绪。

除了愤怒,人的情感从大类上可分为高兴、悲伤、失望、惊讶等面部情感,从内心情感上还可细分为:尴尬、犹豫、赞同、羡慕等。这些情感可以用VAD方法进行量化打分。

所谓VAD,是指Valence、Arousal、Dominance三个衡量维度。

· Valence(效价),指达到目标对于满足个人需要的价值,同一个目标对每一个人可能有三种效价:正、零、负。

· Arousal(积极程度),即精神+身体共同体现出的积极程度,如充满活力或死气沉沉。

· Dominance(优势度),表示个体对情景和他人的控制状态,如愤怒就属于优势度高的情感,而恐惧属于优势度低的情感。

数据堂一直致力于开发个性化的机器训练数据,并将数据和服务落地到AI产品和业务,为人们带去更好的产品体验,让每个人都能享受人工智能带来的美好生活。